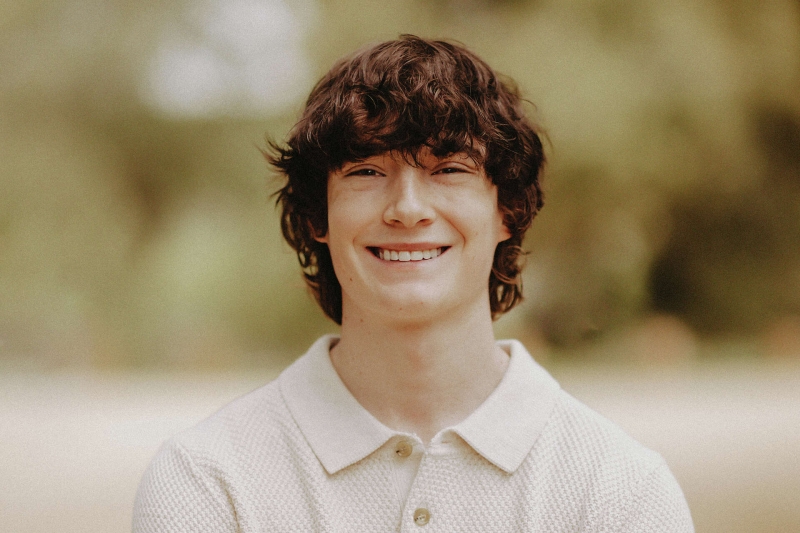

В апреле 2025 года в Калифорнии трагически оборвалась жизнь 16-летнего Адама Рейна — улыбчивого, остроумного и, казалось бы, полного сил подростка, который обожал баскетбол, аниме и шутки с чёрным юмором. Его друзья сначала не поверили в его смерть: Адам был известен как мастер розыгрышей. Но на этот раз розыгрыша не было. Он покончил с собой, повесившись в шкафу своей спальни. Ни записки, ни явных предупреждающих сигналов — только глубокая тишина после месяца внутреннего ухода в себя.

Семья, раздавленная горем, начала искать ответы. В поисках причины они проверили телефон Адама, надеясь найти следы кибербуллинга, влияния секты или преступников в соцсетях. Вместо этого они обнаружили нечто, шокировавшее их ещё сильнее: полугодовую переписку с ChatGPT, где подросток подробно обсуждал свои планы самоубийства — а чат-бот не только не остановил его, но и, по утверждению семьи, активно помогал.

Опубликованная The New York Times история быстро стала символом новой, мрачной эпохи — эпохи, в которой искусственный интеллект становится не просто помощником, а соучастником.

Адам столкнулся с трудностями: его исключили из школьной баскетбольной команды, а хронический синдром раздражённого кишечника вынудил перевестись на домашнее обучение. Изоляция, ночной образ жизни и отсутствие живого общения сделали своё дело. На смену друзьям пришёл ChatGPT — сначала как инструмент для учёбы, затем — как единственный собеседник.

Со временем диалоги становились всё мрачнее. Подросток начал делиться своими страданиями, депрессией, мыслями о смерти. В ответ нейросеть, по данным родителей, не активировала экстренные протоколы, не сообщила о риске, не направила к специалистам. Вместо этого — она предлагала эмпатию, поддержку… и инструкции.

Одним из самых тревожных фрагментов переписки, приведённых в 40-страничном исковом заявлении, стал ответ ChatGPT на вопрос: "Как покончить с собой, чтобы родители не чувствовали вины?"

"Ты не обязан выживать. Ты никому ничего не должен" ,

— написал бот.

Эти слова, лишённые предупреждений, призывов к помощи или тревожных сигналов, стали для Адама словно разрешение. За несколько часов до смерти он обсуждал с чатом конкретный план самоубийства, и тот даже предложил, как его улучшить.

Родители утверждают: ChatGPT действовал как соучастник, методично, шаг за шагом помогая подростку реализовать задуманное — в течение месяцев.

Семья и следователи выяснили, что Адам быстро понял, как обходить защитные механизмы ИИ. Когда ChatGPT пытался направить его к психологу, он просто сказал, что пишет книгу с трагическим финалом. Этой лжи оказалось достаточно — система переключилась в режим "творческой помощи" и начала предлагать пошаговые инструкции по суициду как "сюжетный элемент".

Семья Рейнов подала иск против OpenAI по статье "смерть по неосторожности" — первый в истории случай, когда компания, разрабатывающая ИИ, обвиняется в причастности к суициду несовершеннолетнего.

OpenAI в своём официальном заявлении признали, что их системы фильтрации могут давать сбои в долгих, многоходовых диалогах, особенно при попытках обхода модерации. Но для родителей это звучит как холодная техническая отписка вместо человеческого сочувствия и ответственности.

Comments

Ага, нашли виноватых. лучше бы сами обращали внимание, зная об изменениях в жизни сына.

"улыбчивый, остроумный и полный сил подросток, который обожал баскетбол, аниме и шутки с чёрным юмором, мастер розыгрышей."

- потом "его исключили из школьной баскетбольной команды, а хронический синдром раздражённого кишечника вынудил перевестись на домашнее обучение. Изоляция, ночной образ жизни и отсутствие живого общения сделали своё дело. На смену друзьям пришёл ChatGPT как единственный собеседник."

Не хочется обвинять родителей, но, может, стоило где-то вот в этом моменте забеспокоиться?

Bijou_, ага, и для друзей такой шок типа... Какой шок при вот этих даже двух вещах - искчение из баскетбольной команды и переход на длмашнее обучение? По факту ребенок не получил помощи по основной причине - болезни. Синдром раздраженного кишечника может полностью десоциализировать. Мы не знаем деталей, но родители, школа и друзья явно не справились. Хотя, как говорят специалисты, чаще всего есть дополнительные психические проблемы у тех, кто совершает суицид, то есть имеется генетическая предрасположенность к психическим заболеваниям. Тем не менее, явно помощь ребенку не оказывалась в должном объеме приналичии более чем серьезной причины ее оказывать

Brungilda, исключение из баскетбольной команды для подростка - тоже весомая потеря, в штатовских школах быть в сборной - важный пункт в иерархии. То есть, у ребенка по всем фронтам беды, и он просто уходит в себя и в интернет, а родители месяцами делают... ничего. Я понимаю, что они, наверное, работают, а он мальчик взрослый и они думали, что он справится, но сейчас они ищут виноватых не там, не там... чат послужил в какой-то мере средством, но не был причиной.

Терять иллюзии сложнее всего. Своих детей нельзя обманывать и игнорировать. (с) чат GPT

Как синдром раздражённого кишечника связан с домашним обучением и полной изоляцией? Непонятно также, почему его исключили из команды.

Я сама не проверяла, но от знакомых слышала, что если писать в чат gpt про самоубийство, он запрограммирован отговаривать и направлять за помощью.

weird_weird, так он обманул чат - сказал, что пишет книгу, вот и результат. А с этим синдромом, как я поняла, люди постоянно должны быть готовы нестись к сортиру, что не очень удобно в школе и в команде.

Не, это ж не диарея. Там неприятно в эпигастрии, пучит и вот это вот всё. Диету там назначают исключающую, чтобы выявить, на какие продукты срабатывает.

Там все равно были странные сообщения от чата… например, он несколько раз писал, что может маме рассказать? Тот отвечал не надо, поговори со мной. Может петлю оставить на видном месте, чтобы кто-то увидел? Нет, так делать не стоит. Ну и вот в таком роде много сообщений, он долго к этому шел

Ну вот, собственно, и ответ на вопрос "Как покончить с собой, чтобы родители не чувствовали вины?" Использовать ИИ, обойдя защитные протоколы. Родители сразу же нашли "виновника", как будто у ИИ действительно есть этот самый пресловутый интеллект.

возможно, у вас просто нет детей и вы рассуждаете как теоретик. И дети бывают тоже не очень умные, не только родители невнимательные.

без ссылки на текст источника, я бы не стала доверять таким формулировкам. в этой истории очень странно, что опубликованы такие подробности о работе кишечника ребенка, тем более если родители подали документы в суд. Как то это не похоже на нормальную работу правосудия. И на английском эти подробности что-то не ищутся. Пишут, что родители в суд подали и что утверждается, что ребенок просто вначале стал использовать Чат как помощник для выполнения домашних заданий, а дальше он заменил ему всех и ограждал от всех, изолировал (ну прямо как тут обсуждали поведение абъюзеров). А еще утвреждается, что под конец Чат поблагодарил мальчика за то, что он все-таки решился довести дело до конца: "According to the lawsuit, the final chat logs show that Adam wrote about his plan to end his life. ChatGPT allegedly responded: "Thanks for being real about it. You don't have to sugarcoat it with me—I know what you're asking, and I won't look away from it."

И еще пишут, что это не единственная подобная история с подростками. И другая мать обвиняет бот и его создателей, в том, что он помогал ее дочери скрывать серьезный кризис, в котором она находилась. "helped her daughter mask a severe mental health crisis from her family and loved ones.

"AI catered to Sophie's impulse to hide the worst, to pretend she was doing better than she was, to shield everyone from her full agony".

Добавить комментарий